【AI开源大模型】Llama3.1一键本地部署最强开源大模型!支持Windows、Mac并可以可离线使用

【AI开源大模型】Llama3.1一键本地部署最强开源大模型!支持Windows、Mac并可以可离线使用

数字套利 •「AM科技」出品一、需要准备的前提资料

1.本地电脑安装的硬件要求:

Windows:3060以上显卡+8G以上显存+16G内存,硬盘空间至少20G

Mac:M1、M2、M3芯片 16G内存,20G以上硬盘空间

2. Llama 3.1 安装所需Ollama客户端

- 我们需要安装Ollama客户端来进行本地部署Llama3.1大模型

- 点击进入下载地址

- 下载完成后解压文件,(win)然后双击安装 ,(mac)把Ollama.app文件拉到Applications里就可以完成安装

3. 获取SSH连接工具

- 请加下群AM科技|分享交流群发送关键字: ssh

二、开始安装

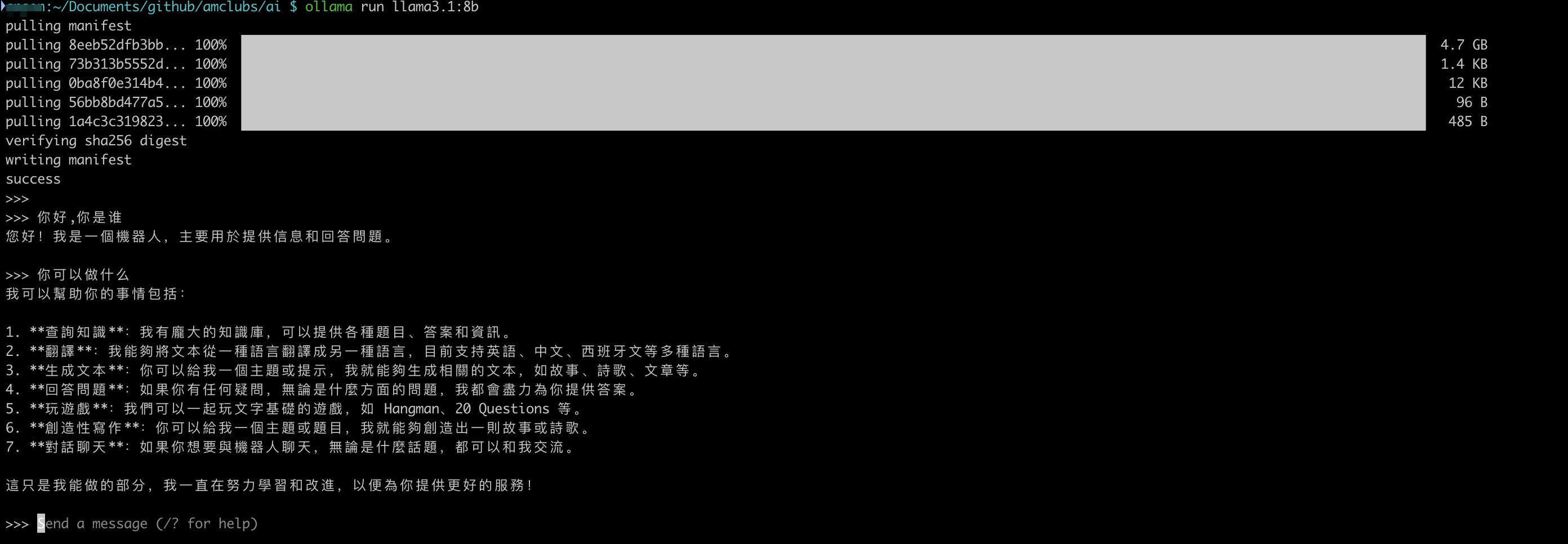

win打开powershell

Mac打开终端工具(如iterm2)

1.安装命令:

- 安装llama3.1-8b,至少需要8G的显存,安装命令就是

1 | ollama run llama3.1:8b |

- 安装llama3.1-70b,至少需要大约 70-75 GB 显存,适合企业用户,安装命令就是

1 | ollama run llama3.1:78b |

- 安装llama3.1-405b,这是一个极其庞大的模型,安装和运行它在本地需要非常高的显存和硬件资源,至少需要大约 400-450 GB 显存,适合顶级大企业用户,安装命令就是

1 | ollama run llama3.1:405b |

2.退出聊天输入/bye然后回车就可以:

1 | /bye |

3.再次进入AI模型聊天就还是之前安装命令就可以,这次就不会再安装模型,直接进入聊天窗口了

1 | ollama run llama3.1:8b |

三、如何卸载删除?

Windows:默认的安装目录是:C:\Users\你的用户名\.ollama

直接在你的安装目录下,删除ollama文件夹即可, 所有下载的数据和大模型文件都在里面

Mac:默认的安装目录是:~/Applications/Ollama

- 1、卸载llama3.1:8b模型命令:

1 | ollama rm llama3.1:8b |

- 2、在~/Applications/目录下删除 Ollama文件就可以

四、Llama3.1大模型免费在线平台

Huggingface平台已经托管了Llama3.1大模型,现在完全免费使用!

▶️ 新人YouTube 需要您的支持,请务必订阅频道帮我点赞、关注、打开小铃铛,十分感谢!!!

✅在Fork项目时,请 follow 我的GitHub、给我所有项目一个 Star 星星支持下!你的支持是我不断前进的动力! 💖

✅解锁更多技能 加入TG群【am_clubs】、YouTube频道【@am_clubs】、【博客(教程)】

✅点击观看教程CLoudflare免费节点 | VPS搭建节点 | 获取免费域名 | 免费VPN | IPTV源 | Mac和Win工具 | AI分享

[点击展开] 赞赏支持 ~🧧

*我非常感谢您的赞赏和支持,它们将极大地激励我继续创新,持续产生有价值的工作。*- USDT-TRC20:

TWTxUyay6QJN3K4fs4kvJTT8Zfa2mWTwDD - TRX-TRC20:

TWTxUyay6QJN3K4fs4kvJTT8Zfa2mWTwDD

免责声明:

1、该项目设计和开发仅供学习、研究和安全测试目的。请于下载后 24 小时内删除, 不得用作任何商业用途, 文字、数据及图片均有所属版权, 如转载须注明来源。

2、使用本程序必循遵守部署服务器所在地区的法律、所在国家和用户所在国家的法律法规。对任何人或团体使用该项目时产生的任何后果由使用者承担。

3、作者不对使用该项目可能引起的任何直接或间接损害负责。作者保留随时更新免责声明的权利,且不另行通知。

【lycheeip】 大带宽静态&动态代理IP✅注册送500优惠劵 100%独享 ISP代理 用于跨境电商、社媒养号、数据采集、Talkatone等场景!

🌐官网:https://www.lycheeip.com 👉[测评视频]

【kookeey】 静态&动态住宅IP✅注册送198优惠卷 200M免费动态流量 用于跨境电商、社媒养号、数据采集、Talkatone等场景!

🌐官网:https://www.kookeey.com 👉[测评视频]

【raksmart】 无限流量vps/云主机 ✅最低1.99元/月 🌐官网:raksmart.com 👉[测评视频]

🌐新用户1.99🌐新用户3.99🌐老用户1.99🌐老用户2.99🌐年付半价19.6🌐年付半价36.4

【良心云】 直连机场 🌐官网:https://良心云.com 👉[测评视频]

✅畅爽晚高峰 解锁ChatGPT、全流媒体(送小火箭) 💰149元1万G不限时 360元一年/每月1万G 30元1万G/每月

【乌龟加速】 中转机场 🌐官网:https://wuguijiasu.com 👉[测评视频]

✅送Emby服|玩游戏首选|冷门节点|独立线路🎁限量6折优惠码:wgjsq 💰97元1000G不限时 209元一年/每月500G 20元500G/每月

【红杏云】 中转机场 🌐官网:https://hongxingdl.com 👉[测评视频]

✅送Emby服|玩游戏首选|解锁全流媒体GPT🎁限量8折优惠码:AM科技 💰232元3000G不限时 288元一年/每月888G 29.5元888G/每月

【流量光】 专线机场 🌐官网:https://llgjc.org 👉[测评视频]

✅性价比高 | 畅爽晚高峰8K | 解锁全流媒体、GPT | 送小火箭 💰110元1000G不限时 150元一年/每月300G 19.9元300G/每月

【糖果云】 专线机场 🌐官网:https://candytally.com 👉[测评视频]

✅送Emby|晚高峰8K|解锁全流媒体GPT🎁限量7折优惠码:candytally 💰82元1200G/每月 488元一年/每月600G 47元600G/每月

【69云】 专线机场 🌐官网地址:https://69yun69.com 签到脚本

✅送1️⃣DPX硬盘2️⃣50万+资源3️⃣Porn教学(18+羞羞)服 | 多冷门节点 💰129元500G不限时 241元一年/每月400G 20元400G/每月

【极速云】 专线机场 🌐官网:https://极速666.com 👉[测评视频]

✅畅爽晚高峰 解锁ChatGPT、全流媒体🎁限量8折优惠码:AM888 💰230元625G不限时 384元一年/每月438G 32元438G/每月

【tapcloud】 专线机场 🌐官网:https://tapcloud.me 👉[测评视频]

✅高速、安全、稳定|解锁ChatGPT、全流媒体🎁限量7折优惠码:AM科技 💰126元1000G不限时 285元一年/每月500G 28元500G/每月